31 Mar 2015 19:19

Mensajes: 1295

Ubicación: Santa Cruz de Tenerife

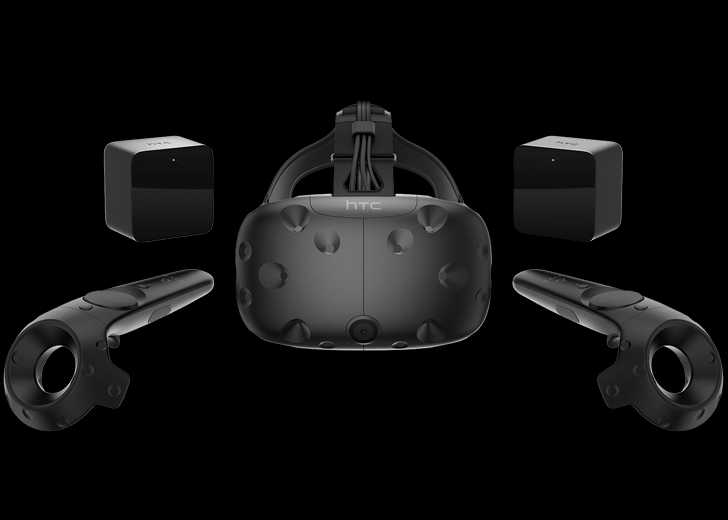

Visores

Ayer noche salio la release de la version 4.10 del motoro Unreal Engine 4, esta vez han tenido especial interes en optimizar el motor para realidad virtual, parece ser que de manera bastante positiva, yo aun no lo he probado, aqui las novedades para VR:

NUEVO: OPTIMIZADO VR RENDERING

""Sus juegos de realidad virtual se vuelven más rápidos en esta actualizacion, gracias a las nuevas optimizaciones de renderizado específicamente para procesado en cascos de rv. Hemos implementado un nuevo "optimización de malla Ocultos y Visible" para reducir la sobrecarga de la GPU de VR renderizado. Tren bala VR demo, por Epic Games Estos dos optimizaciones asegurar que no pasamos tiempo GPU trabajando en píxeles que no se mostrarán en el dispositivo real, debido a las distorsiones de la lente. La malla área oculta trabaja como PrePass, donde tomamos una malla que representa el área oculta a la vista, y rechazamos todo lo que detrás de la malla. A continuación, para la etapa de post-procesamiento, utilizamos la inversa de esa malla, que representa los píxeles visibles, y el procesamiento posterior a continuación sólo se ejecutan en ellos. Mediante el uso de estas dos técnicas, se obtiene un rendimiento "libre"! El "tren bala", vimos un ahorro de aproximadamente 0,25 ms totales en el PC, en el que el tiempo total del marco sólo 11 ms. En las plataformas de consola se puede esperar ver mucho más grandes mejoras de rendimiento! ""

BAJA LATENCIA CONTROLADORES DE MOVIMIENTO VR

""Hemos actualizado Componentes Motion Controller ahora hacer un late-actualización justo antes de comenzar la representación. Usted puede ver la diferencia entre una actualización tardía y una posición del componente y la rotación de abajo no actualizada tarde. La captura de pantalla fue tomada durante un movimiento de la velocidad normal, de lado a lado del brazo.

Esta es la misma técnica que usamos para reducir la latencia con la cabeza montado pantallas. Ahora actualizamos posiciones de movimiento de componentes Controller dos veces por trama: una vez durante la garrapata de entrada, y una vez más la derecha antes de que prestamos. Eso significa que los controles se sentirán más sensible, y reflejar mejor lo que el jugador está haciendo en el mundo real. Esta característica está habilitada por defecto.""

Otros:

Nuevo: Añadido soporte para efectos de retroalimentación háptica, que utilizan curvas de amplitud y frecuencia para definir la respuesta de los jugadores se sientan en sus controladores de movimiento.

Nuevo: Actualizado Oculus Mobile SDK (GearVR) a la versión 0.6.2.

Nuevo: Actualizado Oculus SDK 0.8.

Solución de error: Se ha corregido informes impropia de Is HMD Activado.

Corregido errores de compilación en GearVR Plugin para objetivos no ARMv7.

Aqui el resto de novedades: www.unrealengine.com/blog/unreal-engine-4-10-released?utm_medium=email&utm_campaign=4dot10&utm_source=newsletter_nov