La IA llegará a Quest antes que pantallas con resolución retina

7 MAY 2024 12:20

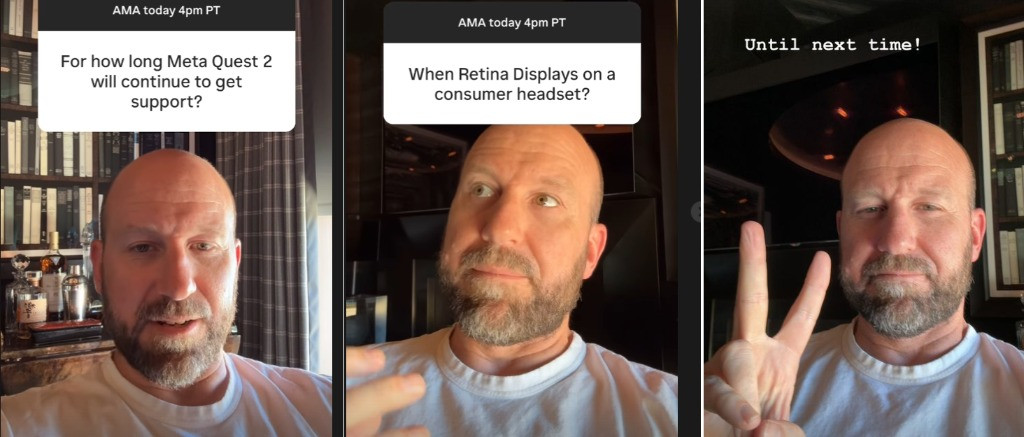

El CTO de Meta Andrew Bosworth ha vuelto a realizar una sesión AMA de preguntas y respuestas desde su cuenta de Instagram, en la que se ha hablado de IA, pantallas con altísima resolución, el futuro de Quest 2 y otras cuestiones relacionadas con la XR que os resumimos a continuación.

La IA integrada en las gafas Ray-Ban Meta no llegará todavía a Quest, porque está pensada para ayudarte a resolver dudas o problemas que suceden en el exterior, en el mundo real, no en el virtual. La IA (LlaMA3 u otros modelos) llegará a los visores, pero Andrew Bosworth no puede desvelar cuando, dice con una sonrisa cómplice insinuando que antes de lo que nos pensamos. En otro momento, explica que cierto grado de IA ya se usa en Quest de alguna manera, para procesos como calcular el seguimiento de cuerpo completo.

La interfaz de Quest se diseñó para mostrar y ejecutar una aplicación, para poder mostrar más ventanas flotantes deben de trabajar en hacerla más capaz de multitarea, y están en ello. No se trata de falta de potencia o capacidad.

Meta Quest 2 sigue a la venta, por lo que como han dicho en muchas ocasiones, su vida comercial será larga y le seguirán dando soporte mucho tiempo, no hay sobre la mesa ninguna fecha para dejar de apoyar el visor más utilizado.

También da respuestas vagas a preguntas como cuándo llegará el "modo viaje" a Quest, y ante el interés sobre cuando podrá haber dispositivos con pantallas "retina", capaces de resoluciones indistinguibles de lo que se consigue con la vista humana, explica las dificultades técnicas para que eso que existe en prototipos puede llegar al mercado de consumo.

cercata

Visores

#31 » Respuesta a Hypernova #30 8 MAY 2024 10:32

La cosa es que las pruebas las han hecho con operaciones de 8 bits, y aun asi consume 40 veces menos de energia ya que solo tienes que hacer una suma, en vez de multiplicar y sumar.

Hypernova

#32 » Respuesta a cercata #31 8 MAY 2024 11:30

Eso es volver a RISC contra CISC. El 6502 en 1975 era más barato, de menor consumo, con menos latencia a la memoria... Que sus rivales cisc de la época como el 8080 y el 6.800, que sobre todo, al multiplicar se atascaban y se calentaban... Pero es que como intentaras hacerlo en el 6502, ese sí que se iba al guano.

MIPS hacia 1989 habían afinado su RISC para que no se quedara parado mientras un coprocesador interno hacía la multiplicación.

La supernintendo también usaba un coprocesador interno para multiplicar (era un clon del 65C02, que iban sumándose mejoras, como en pc engine).

Los RISC de la época estaban muy limitados (todos son hijos y nietos del 6502).

Si a un arm le intentas meter funciones complejas que no vienen de forma nativa en el juego de instrucciones, van a tardar más, varias veces más por hacer 2 o más pasadas, y van a consumir más, con la CPU a tope de carga con lo más complejo que puede hacer todo el rato.

Supongo que avx no deja parado un intel mientras funciona, pero me consta que se calienta un montón al usarlo.

La cosa es que te están hablando de consumo, y si les interesa es por su ratio respecto al rendimiento, para servidores y móviles en el futuro. Del mismo modo que en un móvil generalmente interesa más su ratio potencia rendimiento, o todos montarían apus de amd como las consolas, en vez de socs arm con snapdragon o mediatek.

Pero si el consumo no es la prioridad, será mejor con mayor precisión. Por eso los pc siguen en x86. Y por eso sus juegos usan shaders de 32 bits pero en móviles usan 16.

cercata

Visores

#33 » Respuesta a Hypernova #32 8 MAY 2024 11:36

Las NPUs se parecen mas a las GPUs que a las CPUs, estan pensadas para optimizar unas tareas concretas que se repiten mucho, las CPUs para ser flexibles y poder hacer de todo. De todas formas, en el paper tambien dicen que las bitnets son mejores para ejecutarlas en CPUs ;)

Y respecto a CPUs, pues ARM esta reinando en muchos mercados, y RISC-V viene para quedarse, en Safety se va a imponer seguro.

Por cierto, el M4 tambien está muy centrado en la IA, parece que va a haber IA mas alla de la nube.

cercata

Visores

#34 » Respuesta a Usuario eliminado (7750) #24 8 MAY 2024 13:43

Pues el paper ha tenido buena acogida en la comunidad Open Source de la IA, hay varios modelos ya que se basan en el paper, y estan adaptando adaptando motores de inferencia como LLaMA C++ para poder correr mejor los modelos ternarios con el hardware actual.

https://github.com/ggerganov/llama.cpp/issues/5761

En ese hilo intervienen varios gurus, incluido el autor del paper.

Un posible hardware para modelos ternarios tardará mas ...

Usuario eliminado (7750)

Visores

#35 » Respuesta a cercata #34 8 MAY 2024 14:56

Supongo que por algo el DotCSV se quiso currar el video entonces, porque hay miga en eso.

mes_nit

Visores

#36 » Respuesta a Usuario eliminado (7750) #35 8 MAY 2024 15:44

Hace tiempo nos pusistes un vídeo de la IA generativa ayudando en tareas de realidad mixta, te acuerdas de que video es? Creo que era de meta.

Usuario eliminado (7750)

Visores

#37 » Respuesta a mes_nit #36 8 MAY 2024 16:30

mmm no caigo

mes_nit

Visores

#38 8 MAY 2024 16:59

de marzo, no lo encuentro en rov, el artículo lo explica bien

SceneScript, un enfoque novedoso para la reconstrucción de escenas 3D ai.meta.com/blog/scenescript-3d-scene-reconstruction-reality-labs-research/Hypernova

#39 » Respuesta a mes_nit #38 8 MAY 2024 21:36

Esto sí que es revolucionario, y no pillar carrerilla con 1 o 2 bits en momentos puntuales.

La IA tiene dos grandes problemas, el alto consumo de memoria, y las cajas negras, que los programadores no saben cómo cojones funciona, pero funciona. Como cuando 2 bots de IA que crearon en meta o google para negociar, acabaron inventándose su propio lenguaje indescifrable por economía de lenguaje, sin que estuvieran programadas para ello, y las tuvieron que apagar. Fue hace años.

mes_nit

Visores

#40 » Respuesta a Hypernova #39 9 MAY 2024 2:37

No parece necesitar muchos sensores de detección de profundidad o escáneres, quizás esta pensado para utilizarse con cámaras normalitas y entonces abarataria los costes. Ya no entro si esto va a chutar con quest 2 o si nita mucha memoria. Es la respuesta a la fricción que tiene mapear tu sala y luego que con sensores baratos funcionaria.

Y claro este sistema va a saber todo lo que tienes, objeto por objeto