Las expresiones faciales de los avatares de Meta se adaptan a las voces y sonidos

Hoy 12:30

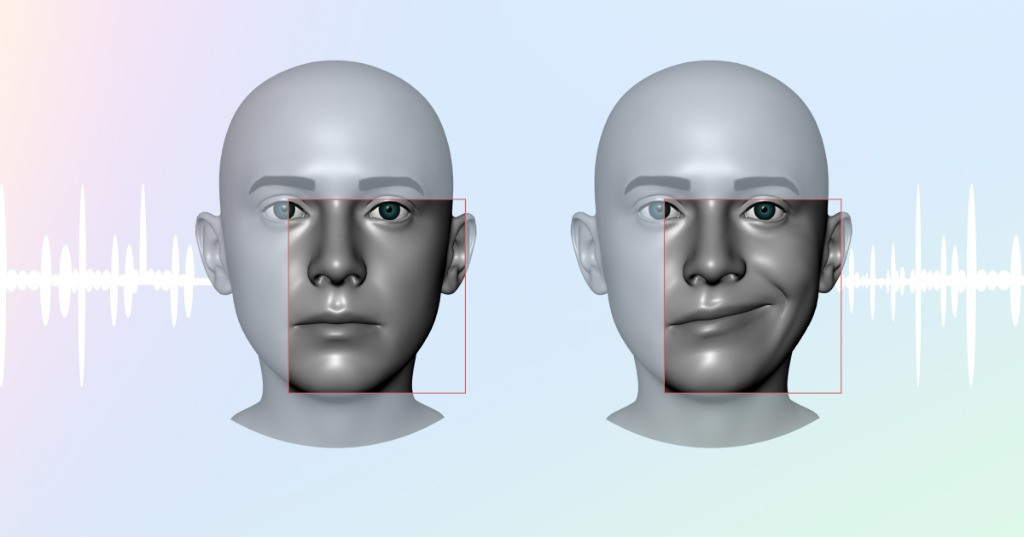

Meta ha añadido la función Audio to Expresión al SDK para desarrolladores, una herramienta que analiza las expresiones verbales y los traduce en expresiones faciales. Sustituye a Lipsync, que tan solo sincronizaba los labios. Ahora, al hablar, aquello que decimos se refleja en el rostro de todo el avatar: boca, mejilla, párpados, cejas, etc.

Resultado de Audio to Expresión (izquieda) frente a Lipsync (derecha)

Este sistema se podrá aplicar a los avatares de los usuarios, y también a NPCs, a los personajes secundarios de los juegos, lográndose un mayor realismo y naturalidad. La clave de esta herramienta es que se utiliza una IA para analizar la voz y sonidos, capaz de interpretar no solo lo que decimos, sino el tono (sorpresa, enfado, alegría) y también risas, toses, etc.

Además de conseguir mejorar la expresividad, otra de las ventajas de este sistema frente al anterior es que solo requiere muy poco uso de CPU y memoria. Eso sí, al basarse en la entrada de audio del micrófono, Audio to Expression no puede representar los movimientos de los ojos, para eso se necesitaría seguimiento ocular, solo disponible en Quest Pro.

Fuente: developers.meta.com